當今科技飛速發展的時代,腦科學與人工智能的融合正催生出一項極具潛力的前沿技術——類腦計算,它有望開啟人類智能與機器智能深度融合的新紀元,徹底改變人與世界的交互方式以及對智能的認知。

類腦計算是腦科學與人工智能深度融合的產物,它旨在借鑒大腦的神經結構和信息處理機制,構建更加高效、智能的計算系統。類腦計算的核心理念是讓機器像大腦一樣思考和學習,通過模擬大腦的神經元網絡和突觸可塑性,實現對復雜信息的并行處理和自適應學習。

腦虎科技創始人兼CEO彭雷此前在接受第一財經采訪表示,長遠來看,腦機接口研究的終極目的就是AI(人工智能)與HI(人類智能)的深度融合,探索人類與機器之間更高效、更直接的交互方式。

類腦計算——下一代人工智能網絡:低能耗,高效率

本輪由ChatGPT引發的人工智能浪潮是基于人工神經網絡(Artificial Neural Networks,ANNs)架構,通過龐大的訓練數據集和高度復雜的結構,讓人工智能在語言理解、生成以及推理方面取得了重大突破。

龐大的數據量意味著頻繁且大規模的運算,隨之而來的是對算力需求的迅猛增長,受制于硬件的供應量,人工智能的進一步發展面臨“算力荒”的瓶頸,優化運行效率和降低計算資源消耗成為人工智能未來發展的一個關鍵方向。

事實上,人工神經網絡是受大腦啟發,但在結構、神經計算和學習規則方面與大腦的生物神經網絡有著根本的不同:大腦的神經元連接是稀疏的,每個神經元只與少數其他神經元連接,這種稀疏連接方式使得大腦能夠在低能耗的情況下高效處理信息;人工神經網絡通常采用完全連接的方式,每個神經元與前一層和后一層的所有神經元連接,這種連接方式雖然能夠模擬人腦處理信息的方式,但導致了極高的能耗。

人工神經網絡的能耗非常高,尤其是大型模型。例如,訓練GPT-3模型需要大約1287兆瓦時(128.7萬度)的電力,相當于美國約121個家庭一整年的用電量。根據相關研究,大腦的總功耗僅為20瓦左右,卻能夠運行非常復雜且龐大的神經網絡。

這意味著如果人工神經網絡可以模仿大腦稀疏型的鏈接方式,優化計算模型,將大幅降低能耗。類腦計算通過模擬生物大腦的工作方式,為實現低功耗、低成本且能夠實時在線學習的人工智能系統提供了新的解決方案。

脈沖神經網絡(Spiking Neural Network,SNN)作為類腦智能的核心計算架構,其工作原理更接近生物神經元的信號傳遞,以脈沖形式的信號和時間序列信息進行通訊,支持異步且稀疏的事件驅動方式。相較于人工神經網絡(ANN),脈沖神經網絡(SNN)有低能耗的顯著優勢。

類腦計算的核心目標是通過學習生物神經系統的結構、功能和機制,進而構建相應的計算理論、芯片體系結構以及應用模型與算法。不同于傳統馮·諾依曼存算分離的特性,類腦計算基于仿生的脈沖神經元實現信息的高效處理,具有低功耗、低延遲的技術優勢,在邊緣計算和實時控制等領域具有廣泛的應用價值和潛力。

關鍵核心硬件——類腦芯片仍待技術突破

類腦計算的技術發展基于硬件平臺、軟件平臺、模型算法和基準數據協同設計和應用。其中硬件平臺的核心就是神經形態芯片和新型存儲器。

傳統的深度學習芯片依賴于馮·諾依曼架構,具有復雜的處理單元和相應的存儲器層次結構,專注于對ANN的執行優化。而神經形態芯片則通常采用非馮·諾依曼分散式多核架構,其中每個核心都將計算與內存緊密耦合。

深度學習芯片追求的是“更快”,更多考慮提高處理速度和計算能力,即性能優先;而神經形態芯片追求“更省”,強調能效比,即效率優先。

新型存儲器主要指憶阻器,它結構簡單、集成密度高,理論上一個就可以實現神經突觸的功能,可極大地提升突觸密度,是從硬件層面實現類腦神經網絡的高效方式之一。

目前神經形態芯片可分為兩大類,一類是僅支持SNN架構,例如IBM TrueNorth、英特爾Loihi、達爾文芯片等;另外一類則支持SNN和ANN的混合計算架構,例如天機芯、英特爾Loihi2、領啟KA200等。

其中達爾文芯片、天機芯、領啟KA200是由浙江大學、清華大學、中科院牽頭研發的類腦芯片。

由浙江大學牽頭研發的達爾文3芯片于2023年發布,相比較達爾文2大幅提升了突觸密度和規模,單芯片能夠支持超過200萬個神經元和1億個神經突觸。

在異構融合類腦芯片領域,由清華大學類腦計算研究中心研發的天機芯是全球首款異構融合類腦芯片。該芯片于2019年8月1日作為封面文章發表在國際頂級學術期刊《自然》(Nature)上,實現了中國在芯片和人工智能兩大領域《自然》論文的零突破。

神經形態芯片雖具優勢,但取代傳統深度學習芯片還為時過早。

首先,人類對大腦的架構和功能仍知之甚少,現有的神經元和突觸模型可能忽略了大腦功能的重要方面,這種對生物系統的不完全理解使得神經形態芯片的設計目標存在不確定性,增加了研發的難度和成本。

其次,神經形態芯片需要模擬生物神經元和突觸的行為,但現有技術難以同時滿足高性能和低功耗的要求。例如,憶阻器雖然能夠模擬突觸的可塑性,但其非線性電阻變化和器件集成的復雜性仍是未來需要解決的問題。此外,大規模突觸陣列的實現也受到器件設計難度和集成復雜度的限制。

短期看,神經形態芯片制造成本高,生態系統尚未完全成熟,大規模推廣仍面臨挑戰。通用計算和大型模型訓練中,CPU/GPU仍不可或缺,未來神經神態芯片與深度學習芯片將互補發展。

中國移動集團首席專家錢嶺在接受第一財經采訪時表示,類腦計算目前僅適用于實時處理和低功耗計算等特定領域,且大都處于實驗室階段,離大規模實用化仍有距離。

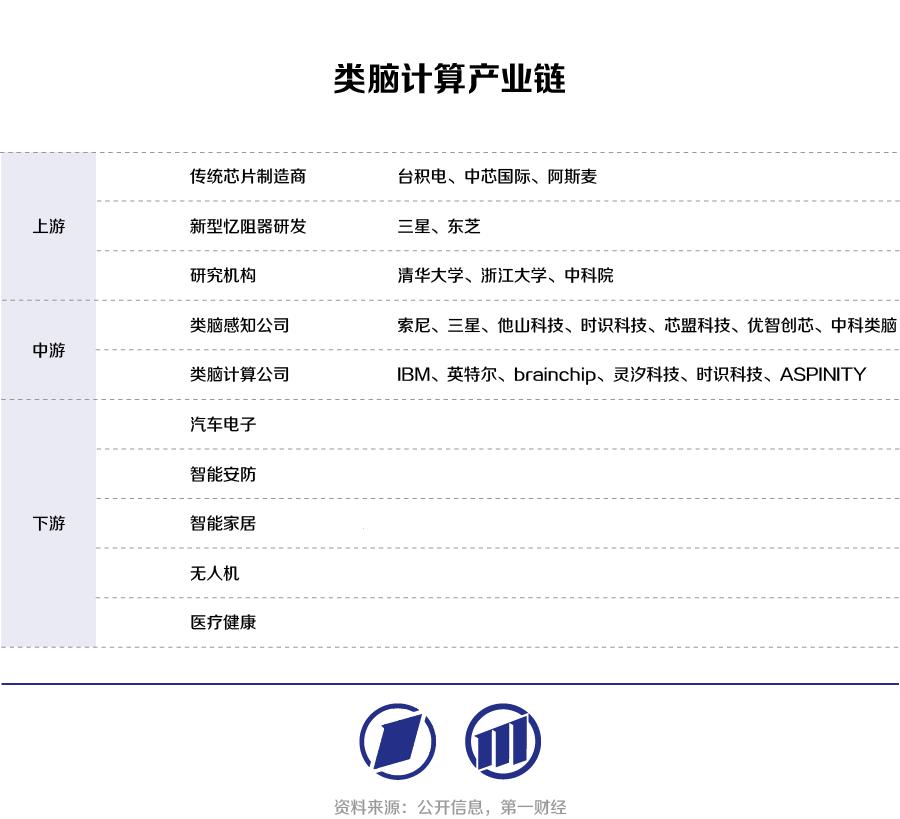

類腦計算下游應用不斷拓展

盡管目前類腦計算仍處于早期階段,但隨著人工智能技術的不斷成熟和普及,類腦計算作為一種傳統計算的高能效替代方案,對于推動人工智能時代的下一波浪潮具有巨大潛力。

據產業研究機構中研普華的《2023-2028年中國類腦計算行業深度分析與發展前景預測報告》,2022年全球類腦計算芯片市場規模約為1.78億元人民幣,中國市場規模也相當可觀,并且呈現出快速增長的趨勢。預計到2030年,中國類腦計算芯片市場規模將接近98億元人民幣(約14億美元)。

隨著類腦芯片的技術突破、大規模仿真平臺的構建,類腦計算的下游應用也將從低維度信息處理和高速視覺處理向端側可穿戴設備、攝像頭和終端設備拓展。

在醫療領域,類腦計算可用于治療神經系統相關的疾病并幫助殘疾人士恢復行動能力;在智能家居、自動駕駛、機器人等領域,類腦計算也將發揮重要作用。在此基礎上,未來將加入在復雜環境中的實時決策能力,在無人機和自動駕駛領域有很大的應用前景。