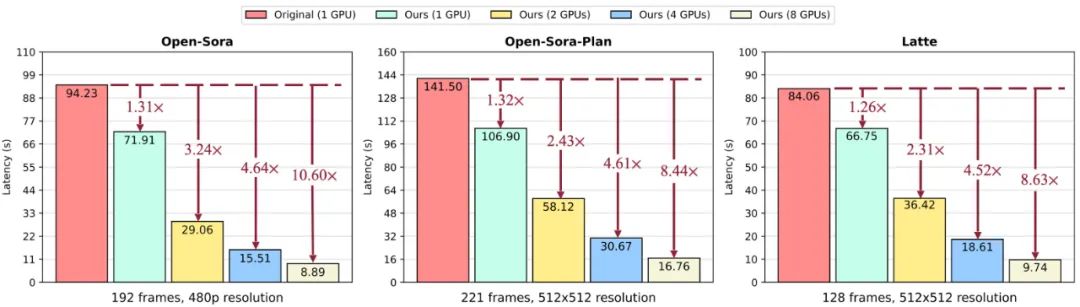

這是團(tuán)隊(duì)在Open-Sora上,使用5個(gè)4s(192幀)480p分辨率視頻進(jìn)行的測(cè)試。

新方法名為Pyramid Attention Broadcast(PAB),由新加坡國(guó)立大學(xué)尤洋以及3位學(xué)生推出。

具體來說,PAB通過減少冗余注意力計(jì)算,可實(shí)現(xiàn)高達(dá)21.6FPS和10.6倍加速,并且不會(huì)犧牲基于DiT的流行視頻生成模型(包括Open-Sora、Open-Sora-Plan和Latte)的質(zhì)量。

作為一種免訓(xùn)練方法,PAB可為將來任何基于DiT的視頻生成模型提供實(shí)時(shí)功能。

看完效果對(duì)比,網(wǎng)友們紛紛驚嘆:

這將是新紀(jì)元。

也引來了眾多專業(yè)人士的轉(zhuǎn)發(fā)和點(diǎn)評(píng),如MIT博士Yilun Du表示:

是一個(gè)展示了如何將視頻生成加速到實(shí)時(shí)速度的酷炫工作!可能會(huì)為視頻策略和模擬的現(xiàn)實(shí)世界用例開辟新的領(lǐng)域。

那么,新方法具體如何破解實(shí)時(shí)生成視頻這個(gè)難題的呢?

減少冗余注意力計(jì)算

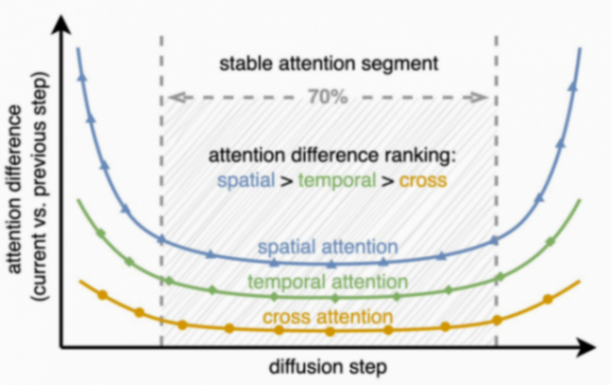

一開始,團(tuán)隊(duì)比較了當(dāng)前擴(kuò)散步驟與前一步驟的注意力輸出差異。

這些差異通過均方誤差(MSE)進(jìn)行量化,并對(duì)每個(gè)擴(kuò)散步驟的所有層進(jìn)行平均。

團(tuán)隊(duì)捕捉到兩個(gè)關(guān)鍵信息:

- 隨著時(shí)間推移,注意力差異遵循U形模式,中間70%差異較小

- 注意力差異的排序為:空間>時(shí)間>交叉

具體而言,不同時(shí)間步驟的注意力差異呈現(xiàn)出U形模式,在第一步和最后一步的15%步驟中發(fā)生顯著變化,而中間70%的步驟非常穩(wěn)定,差異很小。

其次,在穩(wěn)定的中間部分,不同類型的注意力表現(xiàn)出差異:空間注意力變化最大,涉及高頻元素,如邊緣和紋理;時(shí)間注意力顯示出與視頻中的運(yùn)動(dòng)和動(dòng)態(tài)相關(guān)的中頻變化;跨模態(tài)注意力最為穩(wěn)定,它將文本與視頻內(nèi)容聯(lián)系起來,類似于反映文本語義的低頻信號(hào)。

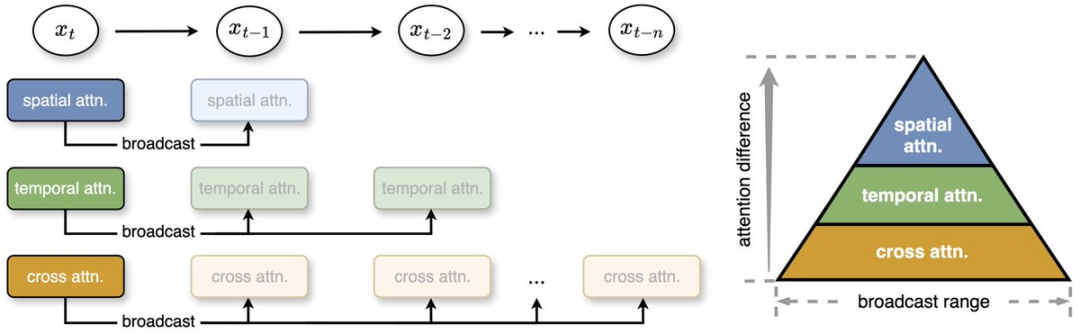

對(duì)此,團(tuán)隊(duì)正式提出用PAB來減少不必要的注意力計(jì)算。

PAB通過根據(jù)每種注意力的差異將注意力輸出到不同的后續(xù)步驟,從而節(jié)省計(jì)算量。

舉個(gè)例子,就像廣播電臺(tái)把一個(gè)信號(hào)發(fā)送給多個(gè)聽眾一樣,如果某個(gè)步驟的注意力結(jié)果在接下來的幾個(gè)步驟中仍然適用,就不需要重新計(jì)算,而是直接使用之前的結(jié)果。

團(tuán)隊(duì)發(fā)現(xiàn),即使沒有后期訓(xùn)練,這種簡(jiǎn)單策略也能實(shí)現(xiàn)高達(dá)35%的加速,并且質(zhì)量損失可以忽略不計(jì)。

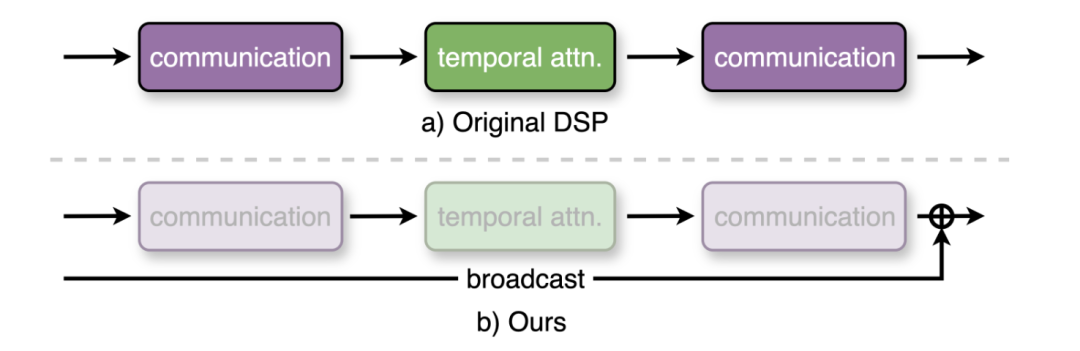

為了進(jìn)一步增強(qiáng)PAB,團(tuán)隊(duì)基于動(dòng)態(tài)序列并行(DSP)改進(jìn)了序列并行。

序列并行通過在多個(gè)GPU上分割視頻以降低延遲,但DSP帶來的時(shí)間注意力需兩次全對(duì)全通信,導(dǎo)致高通信開銷。

而PAB由于時(shí)間注意力不再需要被計(jì)算,使這些通信開銷減少了50%以上,從而優(yōu)化了實(shí)時(shí)視頻生成的分布式推理效率。

借助并行功能,PAB可實(shí)現(xiàn)高達(dá)21.6FPS和10.6倍加速,并且不會(huì)犧牲基于DiT的流行視頻生成模型(包括Open-Sora、Open-Sora-Plan和Latte)的質(zhì)量。