伴隨人工智能的興起,人工智能的安全問題如影隨形。5月21日,歐盟理事會批準了世界首部對人工智能進行全面監(jiān)管的法案《人工智能法案》。同一天,第二屆人工智能安全峰會在韓國首爾召開,包括OpenAI、微軟、智譜AI等全球16家公司共同簽署前沿人工智能安全承諾。然而,目前的監(jiān)管行動是否足以對抗風險,仍是各方疑問。

記者:在韓國開了一個人工智能的全球的一個會議,您關注它的內(nèi)容嗎?

薛瀾:對,我當然也關注。

記者:您最關注它的什么?

薛瀾:一個是,首先這些國家在對人工智能風險的認識,有些什么新的變化?另外關鍵在國際合作機制這方面,大家有什么新的建議。

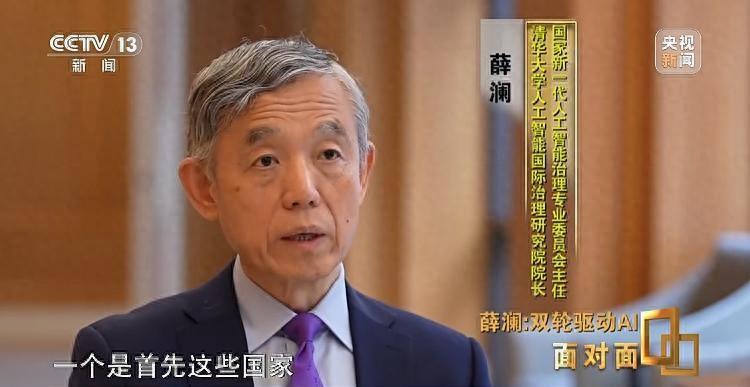

薛瀾,清華大學蘇世民書院院長、人工智能國際治理研究院院長,長期致力于人工智能國際治理重大理論問題及政策需求開展的研究。

薛瀾:對人工智能這個新的技術的發(fā)展,我覺得國際社會這一點是有共識的,它可能會帶來一些風險,大家需要一起來共同合作采取措施,來對它風險防控。

人工智能,英文縮寫為AI,是一種由人制造出來的機器,這種機器可以模擬人的思想和行為,從而體現(xiàn)出一種智能反應。

網(wǎng)絡時代下,不知不覺間,人工智能走進人們的生活。從小愛同學到SIRI到小度,再到第一個擊敗人類職業(yè)棋手的人工智能機器人阿爾法狗,AI呈現(xiàn)出快速進化的趨勢。

薛瀾:舉個例子,很多事情我們要去銀行排隊什么的,可能那就是挺麻煩的事,現(xiàn)在因為咱們有手機銀行,而手機銀行背后一個非常重要的工具其實是人臉識別、指紋識別等等,這背后其實都要用人工智能技術。好比說我要去坐高鐵,我可以通過人臉識別技術一下讓我很快就通過,這當然都是便利。

記者:你的工作或者說你的生活體驗所及的人工智能的觸角,你覺得是已經(jīng)涵蓋到方方面面,還是說這僅僅是露了一個頭而已。

薛瀾:其實我覺得人工智能技術在我們的社會當中,它的應用其實已經(jīng)遠遠比我們想象廣泛,我們社會很多的運行,包括日常開車,覺得今天路上更加暢通,這個背后其實用大量的人工智能技術去調(diào)控整個紅綠燈的交通體系,所以應該說人工智能技術的應用已經(jīng)遠遠超出我們直接能看到的。

近一年來,以CHATGPT和SORA為代表的生成式AI橫空出世,它們以具有龐大參數(shù)規(guī)模和深度學習的大模型為框架,通過海量的數(shù)據(jù)和強大的計算能力進行訓練,實現(xiàn)對各種任務的高效處理。這讓科學家擔心:在不久的未來,人工智能技術會超越人類的智慧,甚至會反過來控制或毀滅人類。著名物理學家史蒂芬·霍金就曾發(fā)出警告——未來100年內(nèi),人工智能將比人類更為聰明,機器人將控制人類。他還與特斯拉CEO伊隆·馬斯克共同發(fā)表公開信,呼吁人工智能的發(fā)展應該受到控制,否則人類可能陷入黑暗的未來。

記者:站在人類的層面上,意識到這樣一個新的技術,有可能在哪些方面會讓我們不安,才會在這種高級別引發(fā)重視?

薛瀾:因為過去的這些各種科技,其實都還是人最后掌控這些技術的。人工智能的話,現(xiàn)在是有可能倒過來了,有可能它不受人控制,有可能它會反過來想要控制人類。

記者:您說人工智能最后會反噬人類這樣一種觀念,是建立在科學基礎之上,還是建立在科幻的基礎之上的一種推測。

薛瀾:我想首先目前的所有人工智能技術都還是在人類社會掌控之內(nèi)的,但是按照這個技術發(fā)展的方向,的確是有相當一部分科學家認為未來是有這種可能的,就是人工智能系統(tǒng)它會不受人類控制,它可能會超越人類控制。

在2024中關村論壇年會開幕式上,全球首個通用智能人“通通”亮相,并入選十大重大科技成果。愛干凈、眼里有活兒、主動做家務、能記住是誰偷吃了蘋果、會耍小脾氣、會感到無聊、無聊時還會自己看電視……“通通”的問世,意味著通用人工智能雛形已成。通用人工智能是要讓智能體像人一樣,不僅能夠獨立感知環(huán)境、進行思考、作出決策、學習新技能、執(zhí)行任務,還能夠理解人類的情感。

薛瀾:它的學習能力,進展迅速。今后慢慢可能這個界限就會比較模糊了,哪些能力是我們?nèi)祟惖摹4蠹覄e忘了,我們的這個能力其實也是逐漸演進而成的,人工智能系統(tǒng)也是這樣的。

在過去相當長的時間里,人工智能脫離人類掌控、反攻人類一直是科幻作品津津樂道的題材。在這些作品中,機器人不僅能獨立思考,還能擁有和人一樣的情感。電影《機械公敵》中,機器人曲解了“機器人三大安全法則”,認為人類間的戰(zhàn)爭將使得人類自我毀滅,遵照“保護人類”的法則,決定將所有人囚禁在家中。

薛瀾:有的研究已經(jīng)看到,某種程度有時候系統(tǒng)已經(jīng)開始有點能欺騙人了,這還是挺可怕的,如果這個系統(tǒng)能知道去有效地自我保護,欺騙人說我聽你的話,但是最后它要實現(xiàn)它自己目標的時候,那它可能就會反過來控制人。

記者:但是我總是覺得機器是騙不了人的,一定是掌控機器的人想做到這樣的一個事情。

薛瀾:這是我們原來傳統(tǒng)的看法,我覺得至少這是很多技術專家,認為不排除它會有這個能力的。在差不多一兩個月以前,我們在頤和園外面一個酒店開會,討論人工智能發(fā)展的時候,當時也是國際上很多專家在一起,當時討論有幾條紅線,這幾條紅線之一就是說我們要保證讓這個系統(tǒng)不能產(chǎn)生這種欺騙的能力,我們要設立一些紅線,到這個地方你就為止了,不要再往前走了。

如果說機器人反噬人類還只是對未來的一種擔憂,那么在當下的現(xiàn)實生活中,尤其在金融領域以及個人隱私保護方面,人工智能帶來的風險已經(jīng)變成現(xiàn)實。

薛瀾:因為我們現(xiàn)在已經(jīng)看到,各種在網(wǎng)上通過這種人工智能技術,可能包括這種換臉,包括可能其他一些方式,給不同的人帶來這種困擾。

不久前,香港一家跨國公司的員工在多位高管參加的視頻會議中,接受指令將2億港幣轉(zhuǎn)到不知名賬戶,5天之后才發(fā)現(xiàn)被騙了。香港警方在通報中稱,以往的AI換臉詐騙,一般都是一對一的。這次騙子用視頻電話會議的形式,偽造了一個高管團隊,讓可信度大幅上升。參與視頻會議的都是真人,然后通過人工智能換臉,把騙子的臉和聲音都換成了對應的高管的臉和嗓音,下達了轉(zhuǎn)賬的指令。

薛瀾:現(xiàn)在通過圖靈測試,已經(jīng)不是難事了,甚至于可能進行網(wǎng)絡的攻擊等等,這些如果有了人工智能技術,那可能使得它的這種攻擊的欺騙性更強,可能帶來的危害更大。

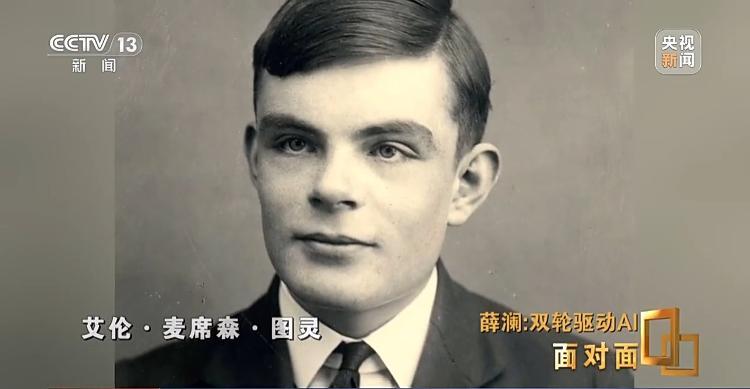

圖靈測試,是被稱作計算機科學之父的艾倫·麥席森·圖靈,在上世紀50年代提出的一個理論——當一個自然人和一臺機器進行對話,在經(jīng)過很多輪對話之后,如果自然人仍然搞不清對方是人還是機器,那么機器就通過了圖靈測試,具備了與自然人相似或無法區(qū)分的智能。如今,文字方面的圖靈測試早已不是問題,隨著sora等軟件的誕生,對于一個圖片或者一段視頻,到底是AI制造的,還是人產(chǎn)生的,兩者之間的差異也越來越難以辨別。

薛瀾:人工智能系統(tǒng)它有創(chuàng)造力,因為我剛看到Sora,當然后來有的專家說它實際上還是學習的東西,不是它去創(chuàng)造的。但是我覺得不管怎么說,一旦你到了這一步以后的話,它有大量的東西以后,創(chuàng)造和記憶之間的界限就模糊了,就像熟讀唐詩三百首,不會學詩也會偷,你慢慢實際上很自然而然就會從大量的語料當中調(diào)出來,那我覺得就是我們?nèi)祟悇?chuàng)造性的某些方面,不排除人工智能系統(tǒng)有這種能力的。

今年初,美國流行歌星泰勒·斯威夫特的AI不雅照在網(wǎng)上瘋傳,數(shù)百萬人在社交媒體上看到了這些照片,美國白宮對此表示“擔憂”,并敦促美國國會立法打擊此類行為。

薛瀾:我們研究科技政策的人都非常知道,這是雙刃劍,它在造福人類的時候,往往也可能會給人類帶來各種風險影響,我們在推進它創(chuàng)新的時候,也要關注它的治理,所以這兩個輪子永遠都必須同時去推進。

上周,AI首爾峰會召開前夕,大會發(fā)布了一份名為《關于先進人工智能安全性的國際科學報告》。報告稱,盡管通用AI可以用來推進公共利益,但也可能被用來造成危害,甚至帶來系統(tǒng)性風險。AI的未來充滿不確定性,但社會和政府的決策將顯著影響其未來。包括美國、法國、中國、韓國以及阿聯(lián)酋在內(nèi)的16家全球領先的科技公司在峰會期間作出的“前沿AI安全承諾”包含了一個重要條款——如果緩解措施無法將人工智能的風險控制在閾值以下,則根本不開發(fā)或部署模型或系統(tǒng)。

記者:當意識到有可能給未來帶來一些風險的時候,我們放慢,甚至也許會停止,那誰來做出這個判斷呢?

薛瀾:我們需要國家和全球治理的機制來做出這個判斷,所以像中國人工智能在2017年的新一代人工智能發(fā)展規(guī)劃里面就明確提到了,我們在發(fā)展技術的同時,也要去建立相應的這種風險防范機制,現(xiàn)在全球在國際社會里面,大家也已經(jīng)形成這樣的共識,盡管我們的意識形態(tài)不同,我們的社會管理體制不同,我們治理體系不同,但是大家都認為我們需要坐在一起來討論這些問題。

今天,越來越多的人堅信,人工智能已經(jīng)成為人類第四次產(chǎn)業(yè)革命的核心驅(qū)動力。以蒸汽、機電和信息技術為基石的前三次產(chǎn)業(yè)革命深刻改變了人類文明的進程,而人類是否能夠更好地應對人工智能產(chǎn)生的沖擊,仍然充滿不確定性。

記者:是不是每一次重大科學技術進步的降臨,都會給人帶來很大的不適,就像我們現(xiàn)在這樣。

薛瀾:我想我們過去這些年用到的很多技術的擴散速度,其實花的時間是很長的,幾十年,甚至于上百年。但這次人工智能的技術,它有一個特點就是技術變革特別快,擴散特別快,所以像ChatGPT一出來,最短的時間用戶達到上億人次,上億人的用戶在過去可能是花多少年的時間,但它只花短短的可能也就是幾十天。

記者:為什么讓人感到如此不安呢?

薛瀾:我們往往會發(fā)現(xiàn)這個技術它在剛開始應用的時候,因為大家研究的就是怎么去造福人類,所以就會特別關注積極的一面,但還有一些風險,可能要過相當一段時間才逐漸展現(xiàn)出來,所以當這技術變革這么快就應用到這么大范圍,我們可能還沒有充分認識到這個技術危害的時候,全社會已經(jīng)在用了,已經(jīng)對它產(chǎn)生依賴了。有可能等到我們認識到它的危害的時候,說不定已經(jīng)為時已晚。可能我們需要去要提前采取這種謹慎的措施,它一旦出現(xiàn),我們能夠有辦法應對。

發(fā)展和監(jiān)管,是治理的一體兩面。但人工智能技術的系統(tǒng)性和專業(yè)性,顯然對治理能力形成新的挑戰(zhàn)。

薛瀾:我們提了一個概念,叫敏捷治理,就是技術發(fā)展得非常非常快,但是我的治理體系,我的改變,其實是很慢的,所以你技術發(fā)展那么快了,我這邊好不容易大家經(jīng)過討論辯論最后達成一致,形成了某一種治理方式,結果一發(fā)現(xiàn),對不起,技術已經(jīng)跑了,已經(jīng)變成新的一個技術,原來討論的方式一點用處都沒有了,所以這時候傳統(tǒng)的治理體系需要進行調(diào)整。

記者:我們怎么理解這個敏捷?就是出了一件事,我得很快速知道怎么去應對,比如說到治理的時候,往往都是說一些政府職能部門,或者說是相關的一些機構,但是我們的學習能力夠嗎?我們的治理能不能做到專業(yè)的水平,或者說我們能不能理解人家的專業(yè)?

薛瀾:因為有的時候就是對人工智能下一步發(fā)展,到底有什么風險,企業(yè)也未見得那么清楚,政府可能就更不清楚。

記者:你說的企業(yè)是人工智能企業(yè)。

薛瀾:就是開發(fā)人工智能技術的企業(yè),所以在這種情況下,那怎么辦呢?企業(yè)就告訴政府,說我現(xiàn)在要發(fā)展這個技術,會帶來什么樣巨大的后果。

記者:為什么要告訴政府?

薛瀾:如果企業(yè)開發(fā)出什么技術,有一些什么風險,政府事先不知道,可能一上來就會非常嚴厲地規(guī)范治理,可能一下子企業(yè)前面做出的各種努力就前功盡棄,付諸東流。但如果說政府和企業(yè)能夠更好溝通,的確這個技術有很好的這種潛力,能夠造福,但也可能有什么樣的風險,可能政府就說我們可來共同討論,什么是我們社會能夠接受的風險程度,在這個之內(nèi),也許你可以更好地發(fā)展。