改善情境化和定制化一直是用戶體驗的長期需求。例如,消費者希望終端能夠自動利用來自智能手機數(shù)據(jù)和傳感器的情境信息和自定義偏好,讓體驗更直觀和無縫,比如基于當前位置、時刻和食物選擇偏好推薦餐廳用餐,創(chuàng)造愉悅體驗。

盡管生成式AI已展現(xiàn)出新興的和變革性的能力,但其仍有很大改進空間。類似多模態(tài)生成式AI等這樣的技術可應對生成式AI更加情境化和定制化的體驗趨勢。

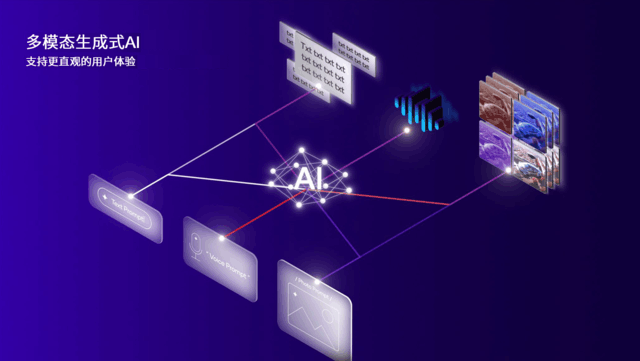

多模態(tài)生成式AI模型輸入和輸出多種模態(tài),以提供更佳響應和答案

多模態(tài)AI模型能夠更好的理解世界

大語言模型(LLM)為純文本訓練模型帶來了驚艷的能力。如果模型能夠支持包含更多知識的不同信息形式,能帶來怎樣的提升呢?

人類能夠通過語言和閱讀文字學到很多東西,但也需要通過各種感官和互動形成對世界的理解:

我們的眼睛讓我們能夠看到球在傾斜地面上滾動的場景,以及當球滾到沙發(fā)后面會如何消失。

我們的耳朵可以識別語音中的情緒或警報聲來源的方向。

我們與世界的接觸和互動讓我們知道如何用手握住泡沫塑料咖啡杯,以及如何在走路時避免摔倒。

類似的例子不勝枚舉。

盡管語言可以描述幾乎所有這些事情,但它可能不如其他模態(tài)做得那么好或那么高效。

正如人類需要利用各種感官學習,生成式AI除了利用文本之外還可以使用更多其他模態(tài)學習:這正是多模態(tài)生成式AI模型的作用所在。

多模態(tài)生成式AI模型可基于一系列模態(tài)進行訓練,包括文本、圖像、語音、音頻、視頻、3D、激光雷達(LIDAR)、射頻(RF)、以及幾乎任何傳感器數(shù)據(jù)。

通過利用所有這些傳感器,融合數(shù)據(jù),并更全面地理解世界,多模態(tài)生成式AI模型可以提供更佳答案。AI研究人員已經(jīng)做到了這一點,他們利用不同模態(tài)的一系列數(shù)據(jù)在云端訓練多模態(tài)大模型(LMM),讓模型更“智能”。OpenAIGPT-4V和谷歌Gemini就是這類LMM。

這能給用戶帶來什么?舉例來說,LMM可以充當通用助手,接收任何模態(tài)的輸入,為更廣泛的問題類型提供大幅改進的答案。比如基于復雜的停車標志回答用戶可否停車,或基于振動噪音回答用戶該如何修理洗碗機故障。

下一步,部署LMM進行推理:盡管生成式AI推理可在云端運行,但在邊緣終端側運行有著諸多好處,比如隱私、可靠性、成本效益和即時性。

例如,傳感器和相應的傳感器數(shù)據(jù)來源于邊緣終端,因此在終端側處理和保存數(shù)據(jù)更具成本效益和可擴展性。

終端側LLM現(xiàn)在具備視覺理解能力

高通AI研究近期演示了全球首個在Android手機上運行的多模態(tài)LLM。我們展示了一個超過70億參數(shù)的大語言和視覺助理大模型(LLaVA),其可接受包括文本和圖像在內的多種類型的數(shù)據(jù)輸入,并生成關于圖像的多輪對話。通過全棧AI優(yōu)化,LLaVA能夠在搭載第三代驍龍8移動平臺的參考設計上以實時響應的速度在終端側生成token。

具有語言理解和視覺理解能力的LMM能夠賦能諸多用例,例如識別和討論復雜的視覺圖案、物體和場景。

例如,視覺AI助手可以幫助視力障礙者更好地理解周圍環(huán)境并與之互動,從而提高生活質量。

終端側LLM現(xiàn)在具備聽覺理解能力

在搭載驍龍XElite的WindowsPC上,高通近期還展示了全球首個在終端側運行的超70億參數(shù)的LMM,可接受文本和環(huán)境音頻輸入(如音樂、交通環(huán)境音頻等),并基于音頻內容生成多輪對話。

音頻提供的更多情境信息可以幫助LMM針對用戶的提示給出更佳答案。我們很高興看到終端側LMM現(xiàn)已支持視覺、語音和音頻模態(tài),并期待對更多模態(tài)的支持。

生成式AI時代剛剛開始,無限創(chuàng)新即將到來

更多終端側生成式AI技術進步即將到來

打造能夠更好理解情境信息的AI模型是獲得更佳答案和體驗提升的必要條件,多模態(tài)生成式AI正是即將應用于未來終端的最新變革性技術之一。歡迎閱讀博客第二部分,我將深入介紹LoRA,探究它將如何幫助應對現(xiàn)有挑戰(zhàn),為消費者和企業(yè)規(guī)模化提供情境化、定制化和個性化體驗。