谷歌也來卷「小」模型了,一出手就是王炸,勝過了比自己參數(shù)多得多的GPT-3.5、Mixtral競品模型。

今年 6 月底,谷歌開源了 9B、27B 版 Gemma 2 模型系列,并且自亮相以來,27B 版本迅速成為了大模型競技場 LMSYS Chatbot Arena 中排名最高的開放模型之一,在真實(shí)對話任務(wù)中比其兩倍規(guī)模以上的模型表現(xiàn)還要好。

如今,僅僅過去了一個(gè)多月,谷歌在追求負(fù)責(zé)任 AI 的基礎(chǔ)上,更加地考慮該系列模型的安全性和可訪問性,并有了一系列新成果。

此次,Gemma 2 不僅有了更輕量級「Gemma 2 2B」版本,還構(gòu)建一個(gè)安全內(nèi)容分類器模型「ShieldGemma」和一個(gè)模型可解釋性工具「Gemma Scope」。具體如下:

- Gemma 2 2B 具有內(nèi)置安全改進(jìn)功能,實(shí)現(xiàn)了性能與效率的強(qiáng)大平衡;

- ShieldGemma 基于 Gemma 2 構(gòu)建,用于過濾 AI 模型的輸入和輸出,確保用戶安全;

- Gemma Scope 提供對模型內(nèi)部工作原理的無與倫比的洞察力。

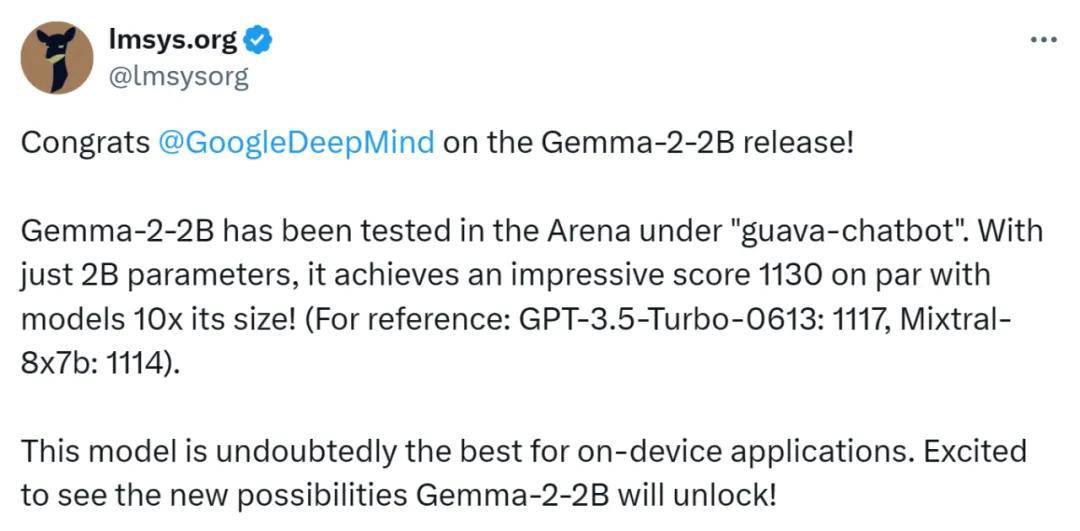

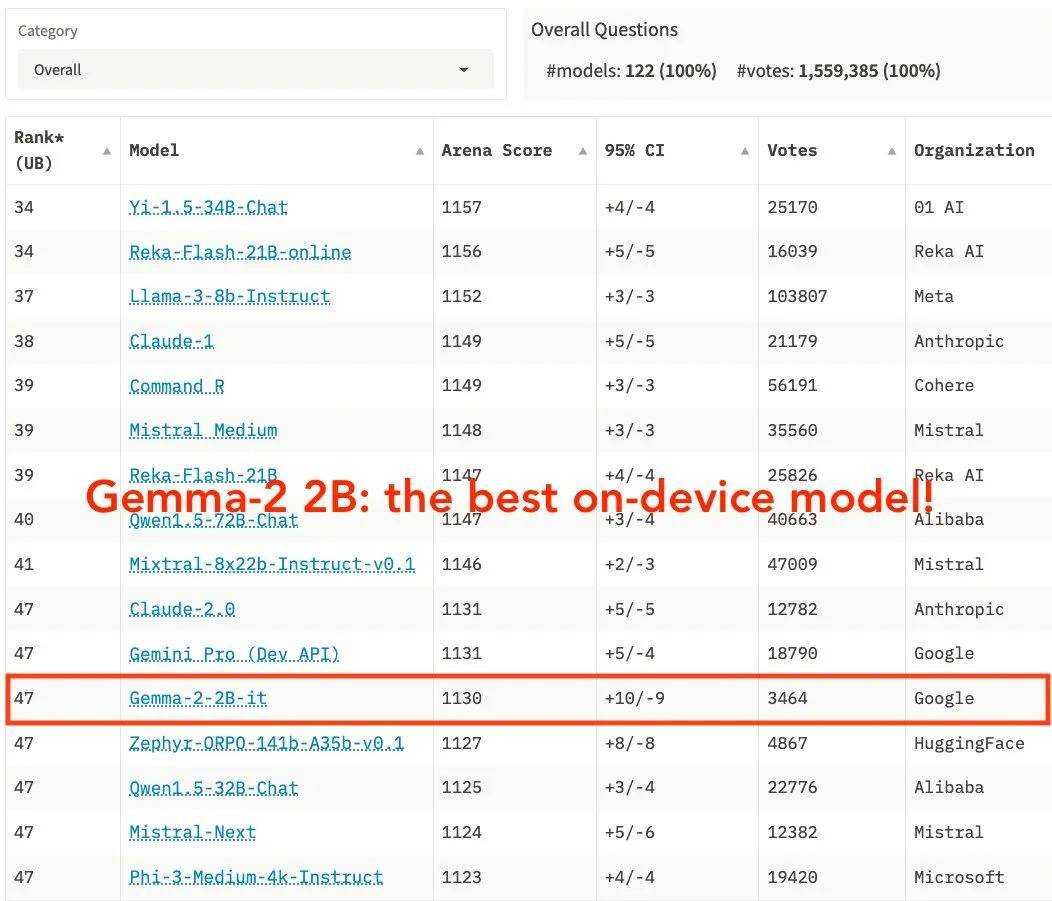

其中,Gemma 2 2B 無疑是「最耀眼的仔」,它在大模型競技場 LMSYS Chatbot Arena 中的結(jié)果令人眼前一亮:僅憑 20 億參數(shù)就跑出了 1130 分,這一數(shù)值要高于 GPT-3.5-Turbo(0613)和 Mixtral-8x7b。

這也意味著,Gemma 2 2B 將成為端側(cè)模型的最佳選擇。

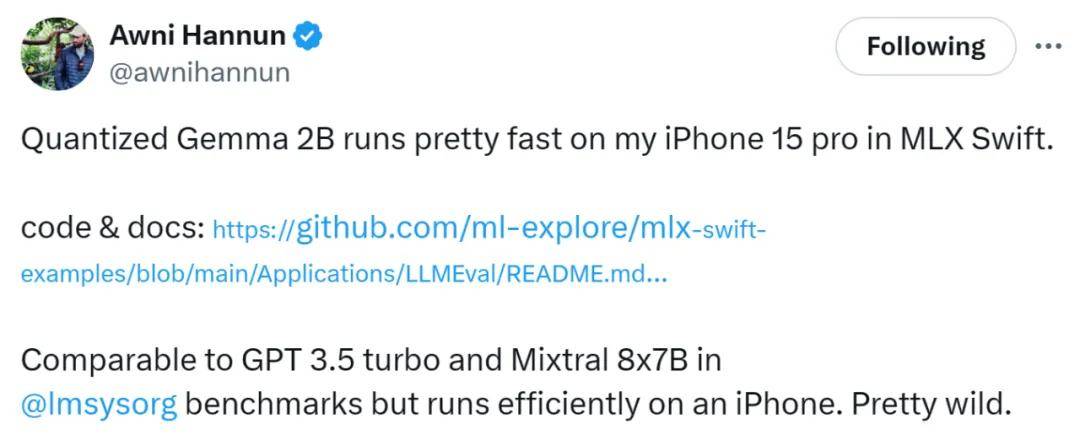

蘋果機(jī)器學(xué)習(xí)研究(MLR)團(tuán)隊(duì)研究科學(xué)家 Awni Hannun 展示了 Gemma 2 2B 跑在 iPhone 15 pro 上的情況,使用了 4bit 量化版本,結(jié)果顯示速度是相當(dāng)快。

視頻來源:https://x.com/awnihannun/status/1818709510485389563

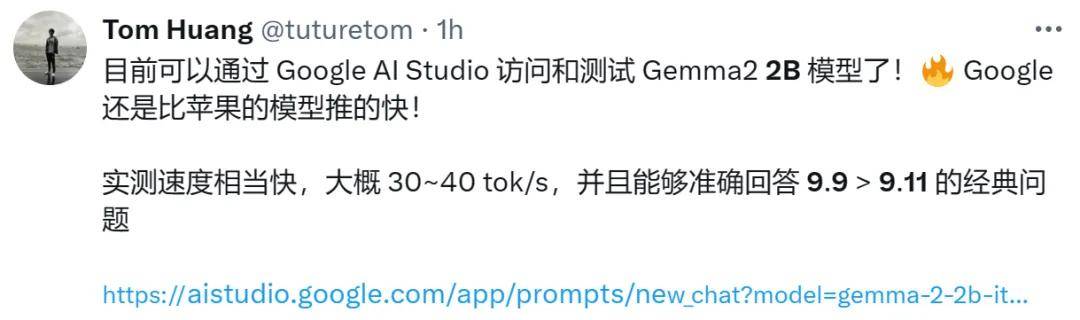

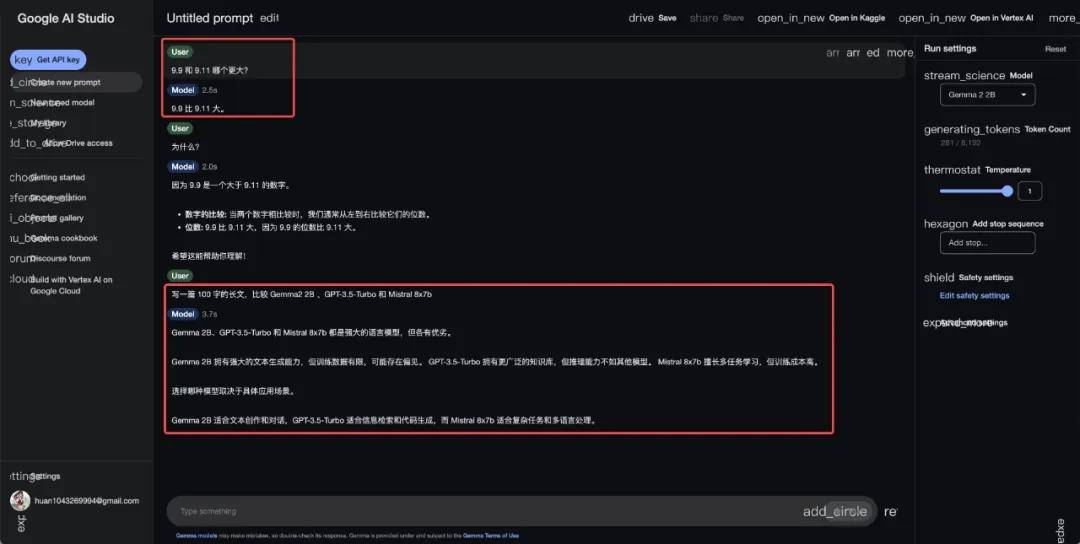

此外,對于前段時(shí)間很多大模型都翻了車的「9.9 和 9.11 誰大」的問題,Gemma 2 2B 也能輕松拿捏。

圖源:https://x.com/tuturetom/status/1818823253634564134

與此同時(shí),從谷歌 Gemma 2 2B 的強(qiáng)大性能也可以看到一種趨勢,即「小」模型逐漸擁有了與更大尺寸模型匹敵的底氣和效能優(yōu)勢。

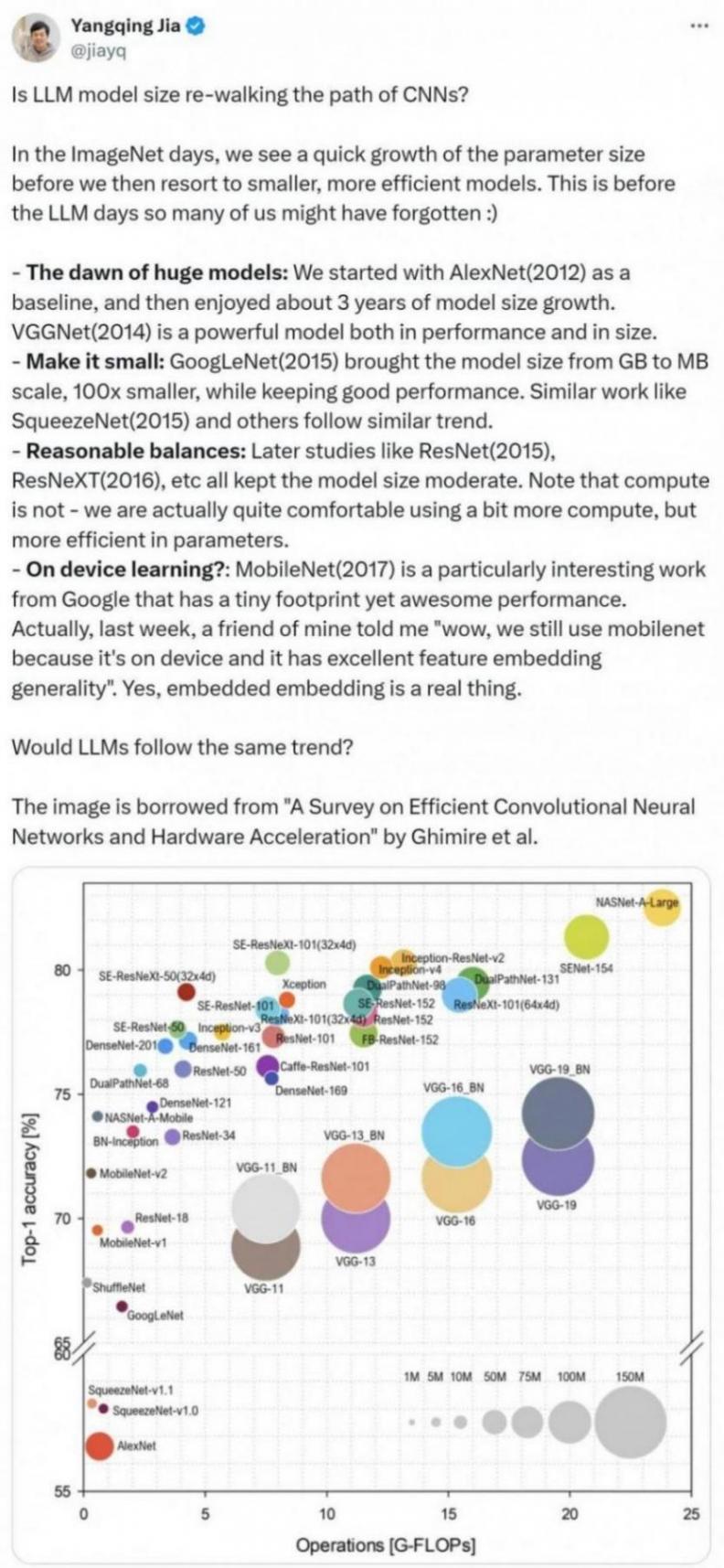

這種趨勢也引起了一些業(yè)內(nèi)人士的關(guān)注,比如知名人工智能科學(xué)家、Lepton AI 創(chuàng)始人賈揚(yáng)清提出了一種觀點(diǎn):大語言模型(LLM)的模型大小是否正在走 CNN 的老路呢?

在 ImageNet 時(shí)代,我們看到參數(shù)大小快速增長,然后我們轉(zhuǎn)向了更小、更高效的模型。這是在 LLM 時(shí)代之前,我們中的許多人可能已經(jīng)忘記了。

- 大型模型的曙光:我們以 AlexNet(2012)作為基線開始,然后經(jīng)歷了大約 3 年的模型大小增長。VGGNet(2014)在性能和尺寸方面都可稱為強(qiáng)大的模型。

- 縮小模型:GoogLeNet(2015)將模型大小從 GB 級縮小到 MB 級,縮小了 100 倍,同時(shí)保持了良好的性能。類似工作如 SqueezeNet(2015)和其他工作也遵循類似的趨勢。

- 合理的平衡:后來的工作如 ResNet(2015)、ResNeXT(2016)等,都保持了適中的模型大小。請注意,我們實(shí)際上很樂意使用更多的算力,但參數(shù)高效同樣重要。

- 設(shè)備端學(xué)習(xí)?MobileNet(2017)是谷歌的一項(xiàng)特別有趣的工作,占用空間很小,但性能卻非常出色。上周,我的一個(gè)朋友告訴我「哇,我們?nèi)匀辉谑褂?MobileNet,因?yàn)樗谠O(shè)備端具有出色的特征嵌入通用性」。是的,嵌入式嵌入是實(shí)實(shí)在在很好用。

最后,賈揚(yáng)清發(fā)出靈魂一問,「LLM 會遵循同樣的趨勢嗎?」