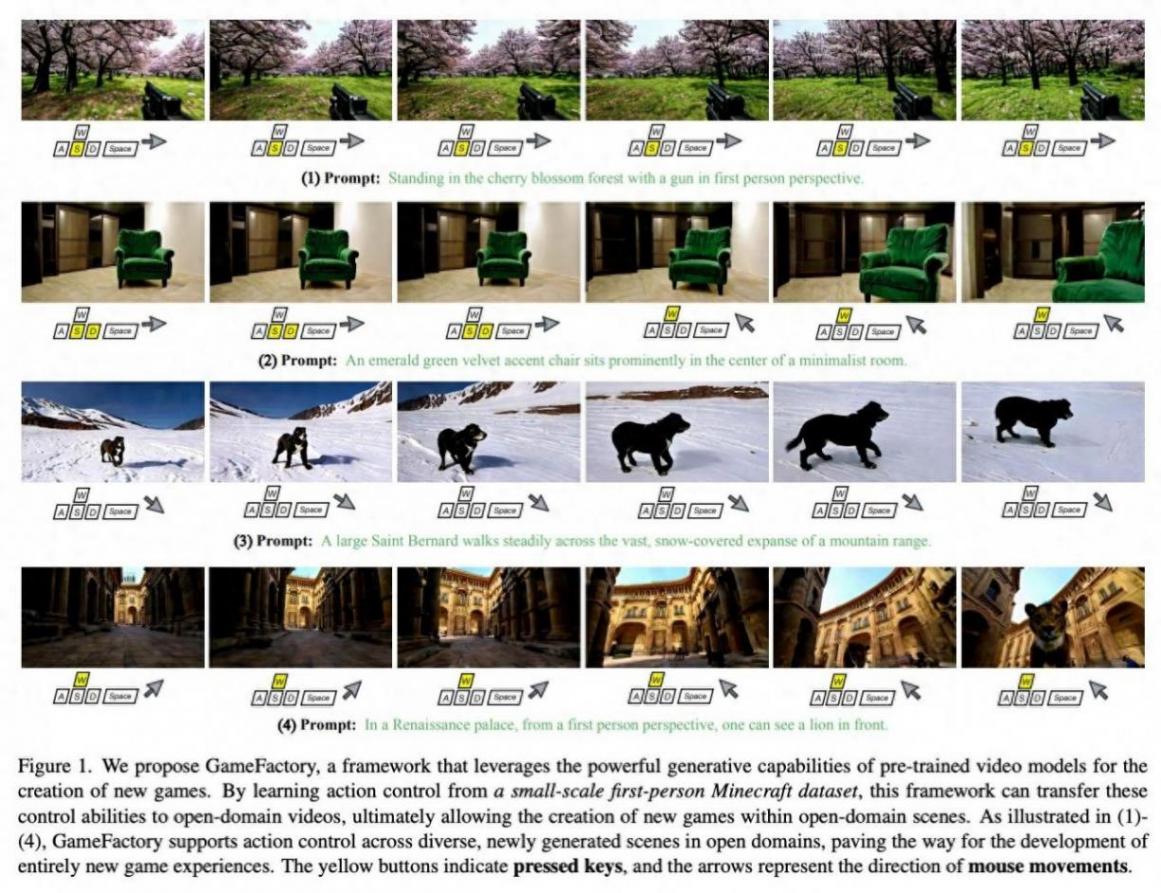

1 月 20 日消息,香港大學攜手快手科技,組建科研團隊,提出名為 GameFactory 的創新框架,目標是解決游戲視頻生成中的場景泛化難題。該框架利用在開放域視頻數據上預訓練的視頻擴散模型,能夠創造全新且多樣化的游戲場景。

項目背景

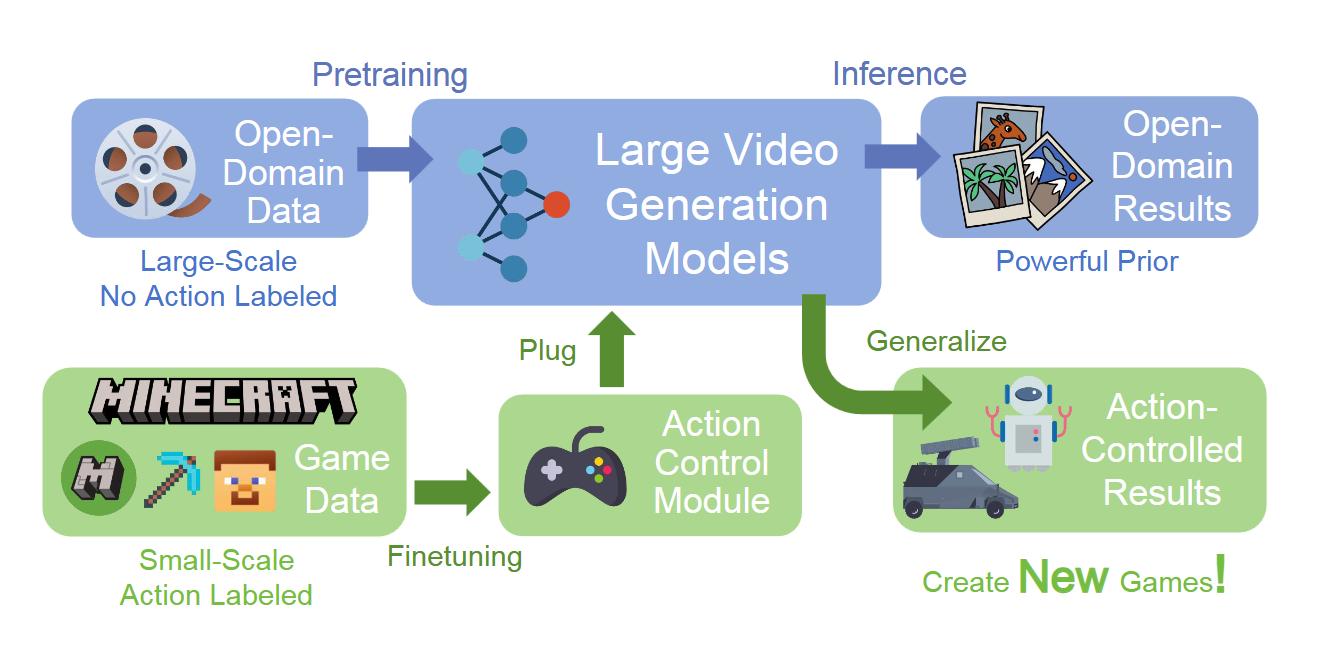

視頻擴散模型已成為強大的視頻生成和物理模擬工具,在游戲引擎開發方面展現出巨大潛力。這些生成式游戲引擎的功能類似于具有動作可控性的視頻生成模型,可以響應用戶的鍵盤和鼠標等輸入。

該領域的一個關鍵挑戰是場景泛化,即創建超越現有場景的新游戲場景的能力。雖然收集大規模的動作標注視頻數據集是實現這一目標最直接的方法,但這種標注成本高昂,對于開放域場景來說并不實際,這種局限性阻礙開發多功能游戲引擎,在生成多樣化和新穎游戲環境方面面臨諸多挑戰。

現有視頻生成和游戲物理學領域也涌現了諸多突破方式,其中一個潛力方向就是視頻擴散模型。這些模型已經從 U-Net 架構發展到基于 Transformer 的架構,從而能夠生成更逼真、時長更長的視頻。

例如,Direct-a-Video 方法提供了基本的相機控制,MotionCtrl 和 CameraCtrl 則提供了更復雜的相機姿態操控。

在游戲領域,DIAMOND、GameNGen 和 PlayGen 等各種項目都嘗試了特定于游戲的實現,但都存在對特定游戲和數據集過度擬合的問題,場景泛化能力有限。

項目介紹

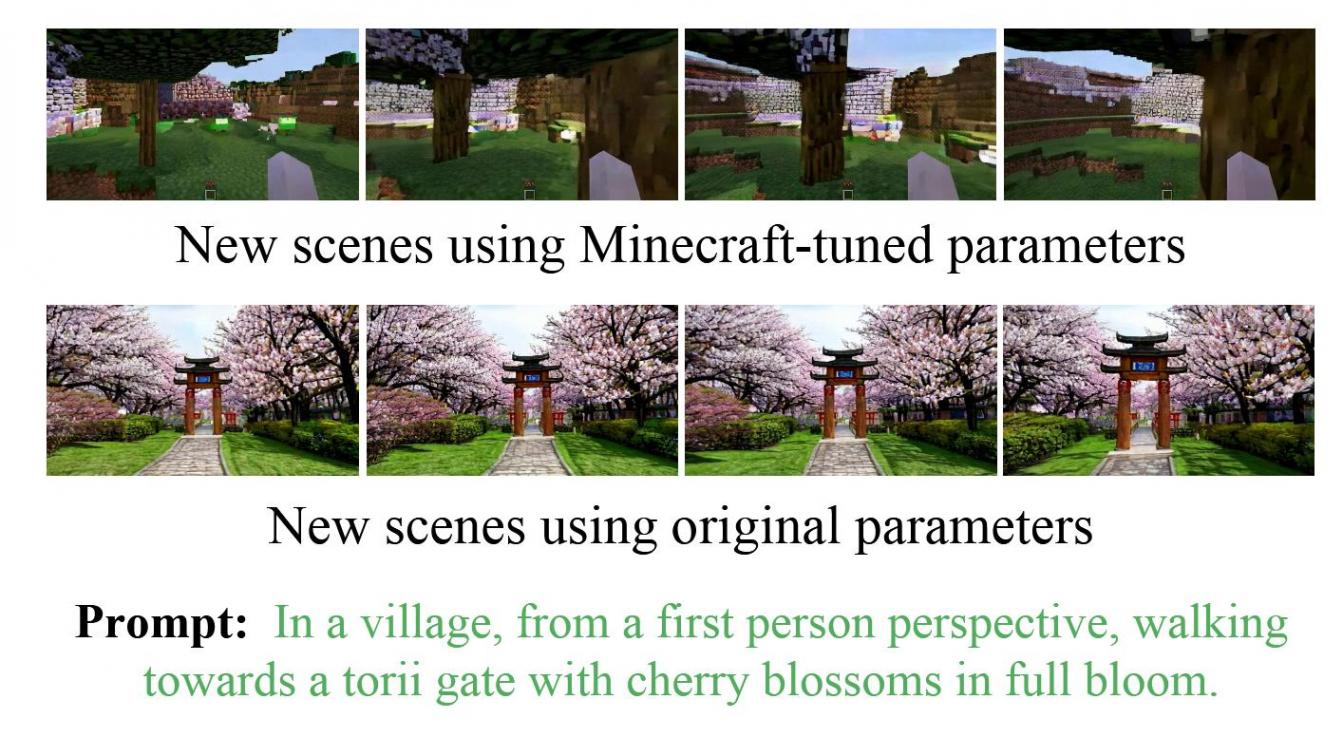

GameFactory 利用預訓練的視頻擴散模型,這些模型在開放域視頻數據上進行訓練,使其能夠生成多樣化的游戲場景,突破了現有方法對特定游戲數據集的過度依賴。

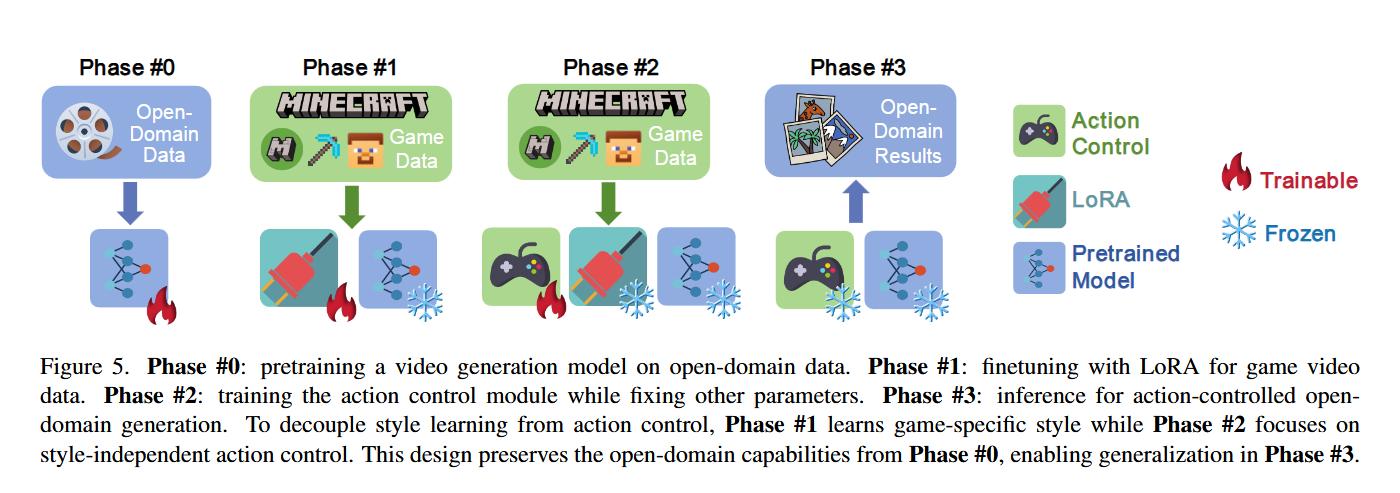

此外,為了克服開放域先驗知識與有限游戲數據集之間的域差距,GameFactory 采用了一種獨特的三階段訓練策略:

-

第一階段:使用 LoRA(Low-Rank Adaptation)微調預訓練模型,使其適應目標游戲領域,同時保留大部分原始參數。

-

第二階段:凍結預訓練參數和 LoRA,專注于訓練動作控制模塊,避免風格與控制的糾纏。

-

第三階段:移除 LoRA 權重,保留動作控制模塊參數,使系統能夠在各種開放域場景中生成受控的游戲視頻,而不局限于特定游戲風格。

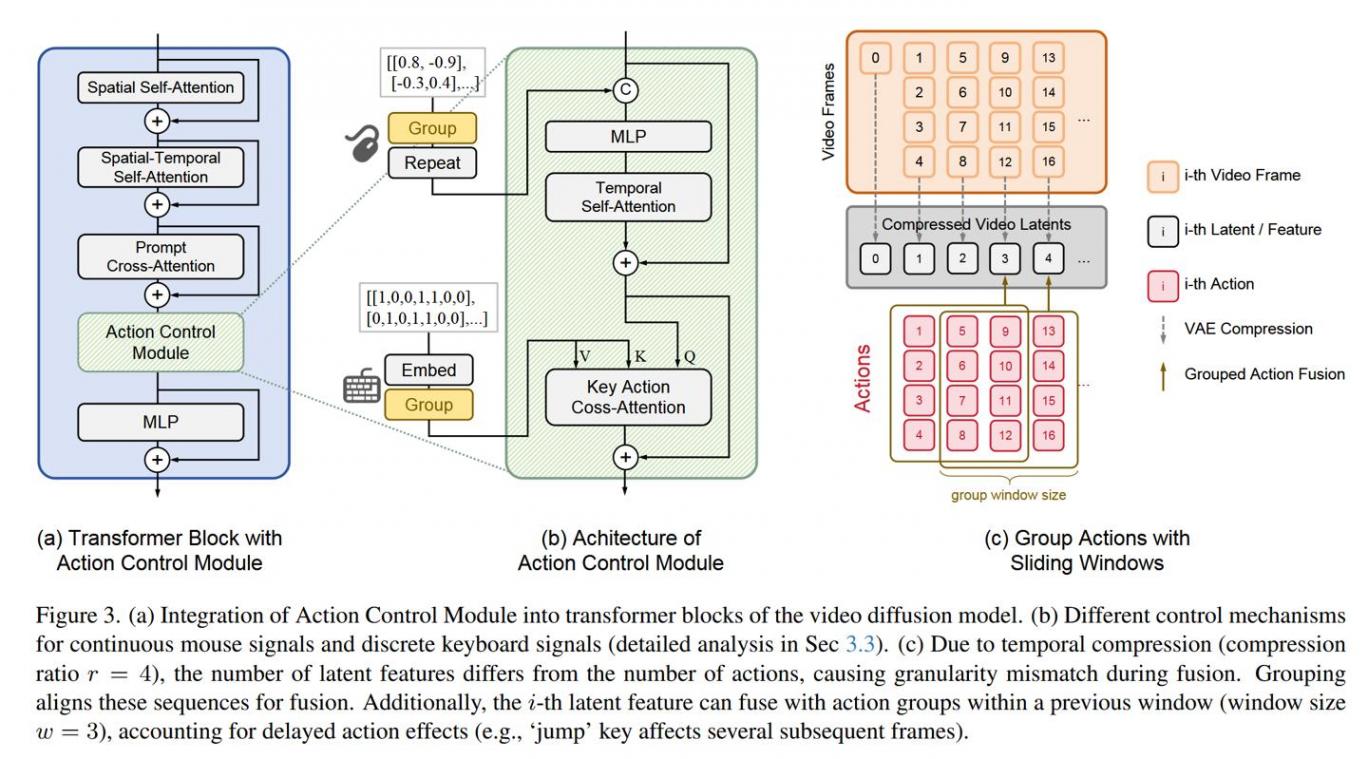

研究還評估了不同控制機制的有效性,發現交叉注意力機制在處理離散控制信號(如鍵盤輸入)方面表現優于拼接方法,而拼接方法在處理連續鼠標移動信號方面更有效,GameFactory 支持自回歸動作控制,能夠生成無限長度的交互式游戲視頻。

研究人員還發布了高質量的動作標注視頻數據集 GF-Minecraft,用于訓練和評估 GameFactory 框架。